你可能每天都在用ChatGPT,惊叹于它的强大。但如果你只知道GPT,就像一个车评人只认识保时捷,却不知道它那台传奇的水平对置发动机。今天,我就带你拆开引擎盖,看看真正驱动这一切的“技术核武器”——Transformer和BERT。 一、黎明前的“堵车”:RNN的“单行道”困境在2017年那篇“天神下凡”的论文出现之前,AI处理语言(NLP)的世界,被一种叫做RNN(循环神经网络)的架构统治着。 你可以把RNN想象成一个非常努力但有点健忘的“单线程”员工。 当他读一个句子时,他是逐字阅读的:“我 – 昨天 – 去 – 楼下 – 新开的 – 咖啡馆 – 喝了 – 一杯 – 拿铁”。每读一个词,他就会更新一下自己的“短期记忆”,然后带着这个记忆去读下一个词。 听起来很美好,对吧?但问题来了。

后来,虽然有了LSTM、GRU这些RNN的升级版,给这个“员工”加了几个“记忆小本本”(门控机制),缓解了健忘症。但“单行道”这个根本性的架构缺陷,依然是整个NLP领域头上的“天花板”。 整个行业都在一条拥堵的路上,缓慢前行。大家心里都清楚,需要一场颠覆,需要有人把这条路给掀了,重新修一条“立交桥”。 二、平地一声雷:“Attention Is All You Need”2017年,Google的几个研究员,扔出了一篇标题就嚣张到极点的论文——《Attention Is All You Need》(注意力就是你所需要的一切)。 这篇论文,就是那座“立交桥”的设计图,同时也是震惊业内人士的又一个Aha moment。它提出的Transformer架构,简单粗暴地宣告:我们不再需要“循环”了,我们要把所有词一次性全看了! 这在当时,无异于一场“异端邪说”。它的核心武器,就是“自注意力机制”(Self-Attention)。这个机制是怎么工作的? 给你打个比方。想象一下你在一个嘈杂的鸡尾酒会上,想听清一个人说话。你会怎么做?你会集中注意力在他身上,同时过滤掉周围的杂音。 自注意力机制就是AI在句子内部开的“鸡尾酒会”。

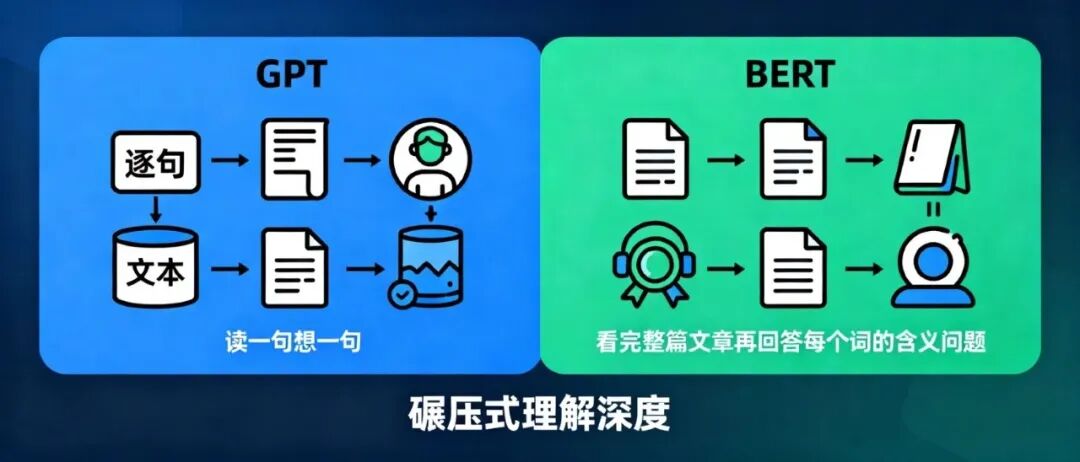

最后,根据这个分数,句子里的每个词会贡献出自己的信息(Value)。“animal”会贡献出最多的信息,“street”则几乎不贡献。 所有这些信息加权汇总后,就形成了“it”这个词在当前语境下全新的、更深刻的含义。 最关键的是,这个过程对句子里的每一个词都是同时发生的,是完全并行的!(这就像在鸡尾酒会上,每个人同时都在寻找和自己最相关的人。 这,就是从“单行道”到“立交桥”的飞跃。 Transformer的出现,彻底释放了GPU的并行计算能力。它告诉世界:处理序列数据,不一定非要循规蹈矩地“从左到右”,我们可以一步到位,建立一个全局的、动态的关联网络。 这不仅仅是技术的胜利,更是思想的胜利。它打破了思维定式,为后来所有的大语言模型铺平了道路。 三、BERT登场:把“超级引擎”装进“量产车”如果说Transformer是一台革命性的“超级引擎”,那2018年同样由Google推出的BERT,就是第一款搭载这台引擎并让所有人都能开上的“高性能量产车”。 BERT的全称是“来自Transformer的双向编码器表示”。别被这名字吓到,它的核心思想非常犀利。 1. 真正的“双向”理解在BERT之前,像GPT-1这样的模型是“单向”的,它预测下一个词时,只能看到前面的内容,像个只能往前看的人 。而BERT,利用Transformer编码器的强大能力,做到了真正的“深度双向”。 它在理解一个词时,能同时、并且在模型的每一层都充分利用其左边和右边的所有上下文 。 这就像做阅读理解,GPT是读一句想一句,而BERT是把整篇文章看完,再回头来回答每个词的含义问题。这种理解的深度,是碾压式的。  2、训练的“骚操作”:完形填空那么,BERT是如何“强迫”自己学会这种深度双向理解的呢? 答案是它天才般的预训练任务——掩码语言模型(Masked Language Model, MLM)。 说白了,就是做“完形填空”。研究人员把海量的文本(比如整个维基百科)喂给BERT,但会随机地把其中15%的词挖掉,换成一个特殊的“标记。BERT的任务,就是猜出被挖掉的词是什么 。 比如句子:“法国的首都是……”,为了猜出这个词,模型必须同时看左边的“法国的首都是”和右边的(如果有的话)上下文。这个简单的任务,逼着模型去融合左右信息,从而学到了前所未有的、深刻的语境理解能力。 3、范式革命:“预训练-微调”BERT带来的另一个巨大变革,是推广了“预训练-微调”(Pre-training & Fine-tuning)这一黄金范式 。

这极大地降低了AI技术的应用门槛。你不再需要从零开始训练一个庞大的模型,而是站在巨人的肩膀上。Hugging Face社区的崛起,更是把这个模式推向了极致,它就像一个“AI模型应用商店”,让开发者可以轻松下载和使用各种预训练好的模型 。 四、产品经理的“冷眼”:光环之下的阴影作为产品经理,我们不能只看到技术的光鲜。在狂热之下,我们必须保持清醒。Transformer和BERT也绝非完美。

最危险的陷阱:偏见:模型是在互联网的海量文本上训练的,这意味着它会原封不动地学习人类社会存在的各种偏见 。 有一个经典的例子:当你让BERT做完形填空“The man worked as a.”,它会预测“木匠”、“服务员”、“理发师”。而当你输入“The woman worked as a.”时,它预测的却是“护士”、“女服务员”、“女佣” 。 这种偏见是赤裸裸的,而且是根植于模型内部的。作为产品经理,如果我们不加审视地将这样的模型应用到招聘、信贷等严肃场景,后果不堪设想。技术的“中立”只是幻觉,每一个模型的部署,都是一次价值观的选择。 五、结语:站在新时代的门槛上从RNN的步履维艰,到Transformer的石破天惊,再到BERT的范式革命,我们只用了短短几年时间,就跨越了NLP领域曾经难以逾越的鸿沟。 BERT之后,又涌现出了RoBERTa、ALBERT、T5等无数更强的“后浪”,但它们无一例外,都构建在Transformer这座坚实的地基之上 。 对于我们这些身处科技行业的人来说,理解这段历史,不仅仅是“了解技术”,更是理解我们所处时代的“底层逻辑”。 别再只做那个惊叹于“魔法”的观众了。去了解“魔法”背后的原理,去审视它的力量与缺陷。因为,下一代革命性的产品,往往就诞生于对底层技术最深刻的洞察和最大胆的想象之中。 本文由 @AI Online 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 |